ИИ для анализа таблиц Excel: как использовать нейросеть для анализа данных без ошибок

Вы загружаете в ChatGPT таблицу продаж на 5 000 строк и просите проанализировать выручку по регионам за квартал. Через несколько секунд получаете уверенный ответ:

«Общая выручка составила 8,4 млн рублей. Лидирует Москва с показателем 2,3 млн (27% от общего объёма), на втором месте Санкт-Петербург — 1,8 млн (21%). Заметен значительный рост в Екатеринбурге — плюс 43% к предыдущему кварталу. Рекомендую обратить внимание на падение показателей в Казани — минус 18%, возможно, стоит пересмотреть стратегию продаж в этом регионе».

Звучит как отчёт опытного аналитика: конкретные цифры, проценты, даже практические рекомендации. Проблема в том, что всё это модель с высокой вероятностью целиком выдумала. Она не открывала вашу таблицу построчно, не суммировала ячейки, не сравнивала периоды. Она просто сгенерировала текст, который выглядит как анализ данных, основываясь на миллионах похожих отчётов из обучающей выборки. В реальности в вашей таблице может вообще не быть Екатеринбурга, Москва может показывать не рост, а падение, а общая сумма — отличаться в разы.

Почему ИИ так убедительно ошибается в анализе таблиц Excel

Проблема в том, что языковые модели не «понимают» таблицу — они лишь генерируют правдоподобный текст, потому что натренированы именно на это. Когда нужно посчитать сумму по колонке или найти максимальное значение, модель не выполняет расчёт — она буквально угадывает ответ, который звучит убедительно.

Чем больше данных, тем хуже результат

Интуитивное ожидание при работе с таблицами: показать ИИ весь Excel-файл, чтобы он «видел полную картину». Это логично для человека, но не работает для языковых моделей. Реальность: чем больше строк попадает в контекст модели, тем выше вероятность того, что она вообще не сможет корректно разобраться в данных. Причина — переполнение контекста. Модель обрабатывает данные последовательно, и при большом объёме она физически не способна удержать всю таблицу в «поле зрения». Это приводит к проблемам:

- Рост галлюцинаций: модель заполняет пробелы правдоподобными, но полностью вымышленными значениями.

- Рост стоимости запроса: обработка больших таблиц требует значительного объёма токенов - можно сжечь все лимиты за один запрос

- Потеря данных: модель пропускает целые разделы таблицы или вообще не видит их корректно. Исследования показывают, что при большом запросе модели гораздо лучше фокусируются на начальной и конечной частях запроса, и склонны "забывать" середину.

- Ошибки в вычислениях - языковые модели в общем не заточены на математические операции, а большие объемы данных только усугубляют эту проблему

Решение: структура данных и точные инструменты вместо полного контекста

Искусственный интеллект для анализа данных в SecureGPT работает иначе, чем стандартные языковые модели — нейросеть не видит данные целиком. Вместо этого она получает краткое структурное описание excel-файла:

- Названия колонок и их типы (число, текст, дата).

- Примеры значений из каждой колонки — достаточно 3-5 строк, чтобы понять содержание.

- Диапазоны дат, если таблица содержит временные ряды.

- Количество строк, столбцов, листов, и тд., для понимания масштаба данных.

Когда нужен конкретный результат — вычисление метрик по колонке, анализ временной динамики, группировка по категориям — анализ эксель-таблицы нейросеть выполняет не напрямую. Вместо этого она формирует запрос к специализированному инструменту, который заточен под точные аналитические операции в рамках конкретной задачи. Таким образом, вычисления происходят детерминированно, без угадывания, а модель получает лишь финальный, гарантировано точный результат.

Меньше данных в контексте → меньше ошибок → выше надёжность. Модель не пытается удержать в «памяти» весь файл — она управляет инструментами, которые извлекают только нужную информацию.

Реальный пример: как должно работать

Финансовый директор загружает выгрузку из 1С — файл на 50 000 строк с движением денежных средств за год. Задаёт вопрос: "В каком квартале была максимальная просадка по денежному потоку?"

Что видит модель:

- Файл: cashflow_2024.xlsx

- Колонки: Дата, Приход (число), Расход (число), Контрагент (строка)

Примеры строк

- 2024-01-05 — Приход: 450 000, Расход: 230 000, Контрагент: ООО «Поставщик А»

- 2024-01-12 — Приход: 0, Расход: 890 000, Контрагент: ООО «Аренда офиса»

- 2024-01-20 — Приход: 1 200 000, Расход: 0, Контрагент: ООО «Клиент Б»

Диапазон дат: 2024-01-01 → 2024-12-31

Всего строк: 50 000

Действия модели под капотом:

- Вызывает инструмент для группировки данных по кварталам (Q1, Q2, Q3, Q4)

- С помощью отдельного инструмента вычисляет суммы столбцов поступлений и расходов для каждого квартала

- С помощью встроенного калькулятора рассчитывает кассовый разрыв (приход минус расход)

Ответ пользователю:

"Максимальная просадка была во 2 квартале: −2,3 млн руб. Основные причины: крупные платежи за аренду (апрель) и задержка поступлений от ключевого клиента (май). В июне ситуация выровнялась."

Таким образом, модель обработала 50 000 строк, но "держала в памяти" только структуру и финальные цифры по 4 кварталам. Как итог — точные и предсказуемые результаты, минимум галлюцинаций.

Как начать работу с агентом (пошагово)

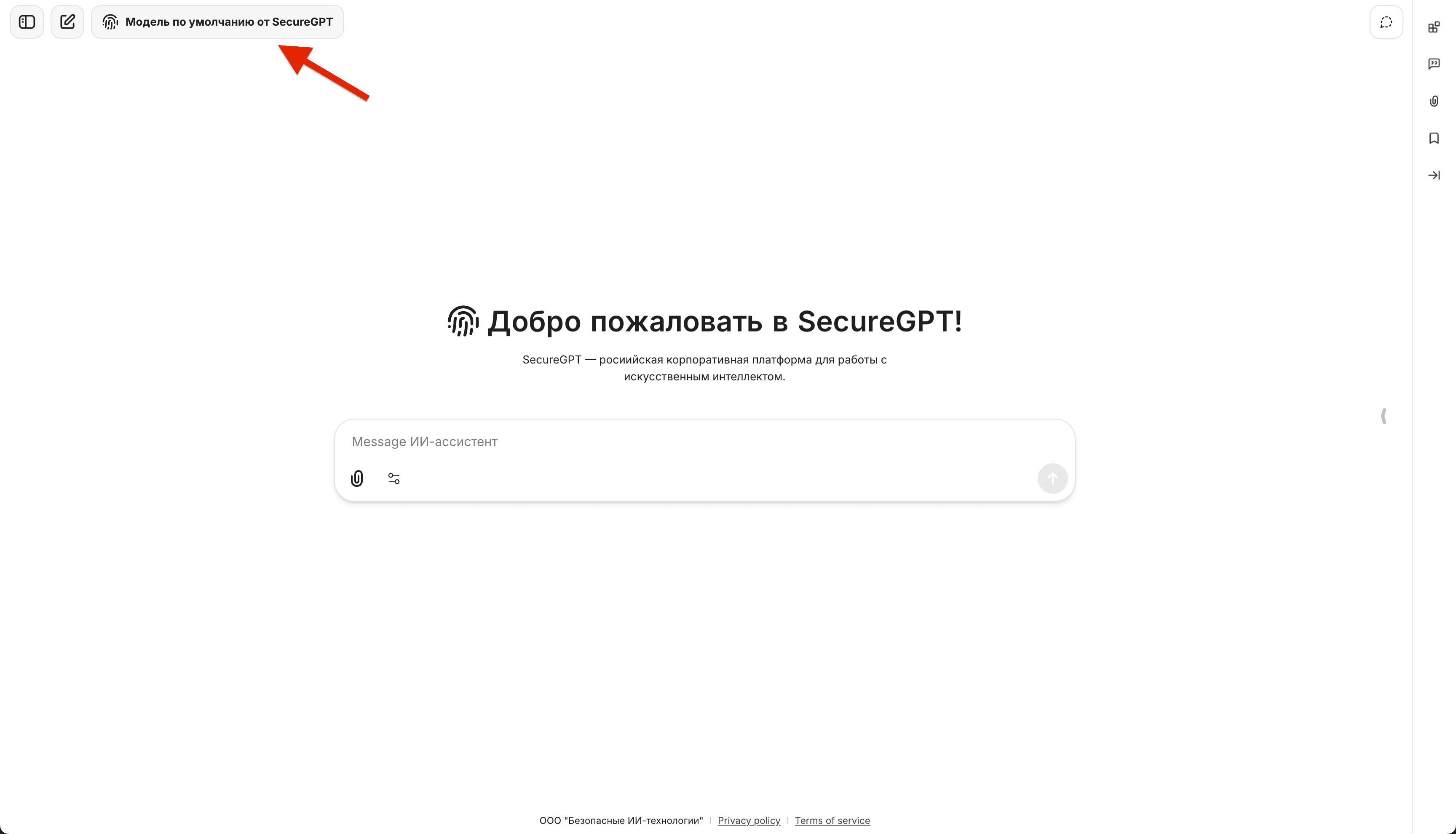

Шаг 1: Откройте интерфейс SecureGPT

Перейдите в основной рабочий интерфейс платформы.

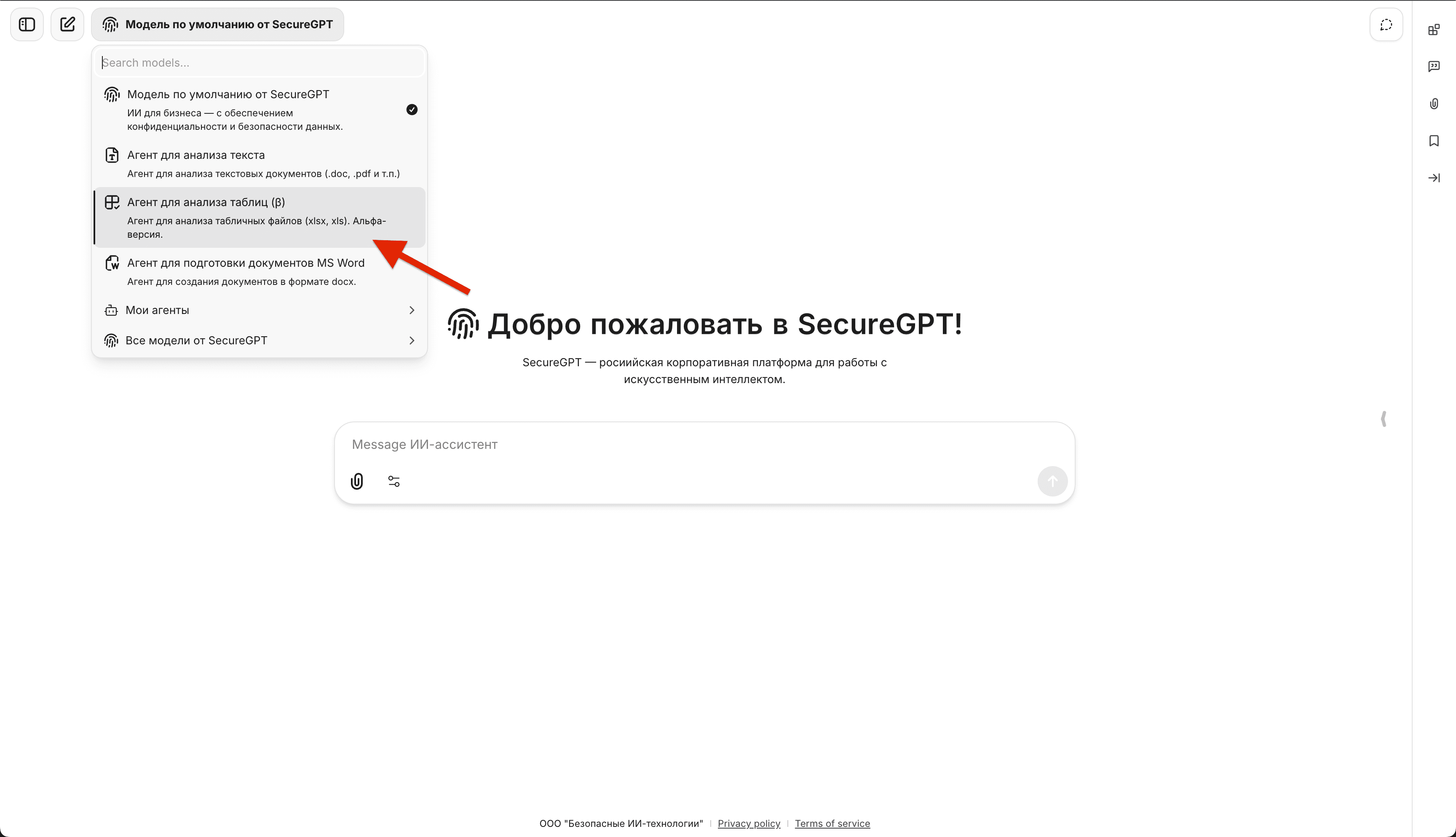

Шаг 2: Выберите агента для анализа таблиц

В левом верхнем углу найдите меню выбора моделей и агентов. Выберите «Агент для анализа таблиц» из списка доступных помощников.

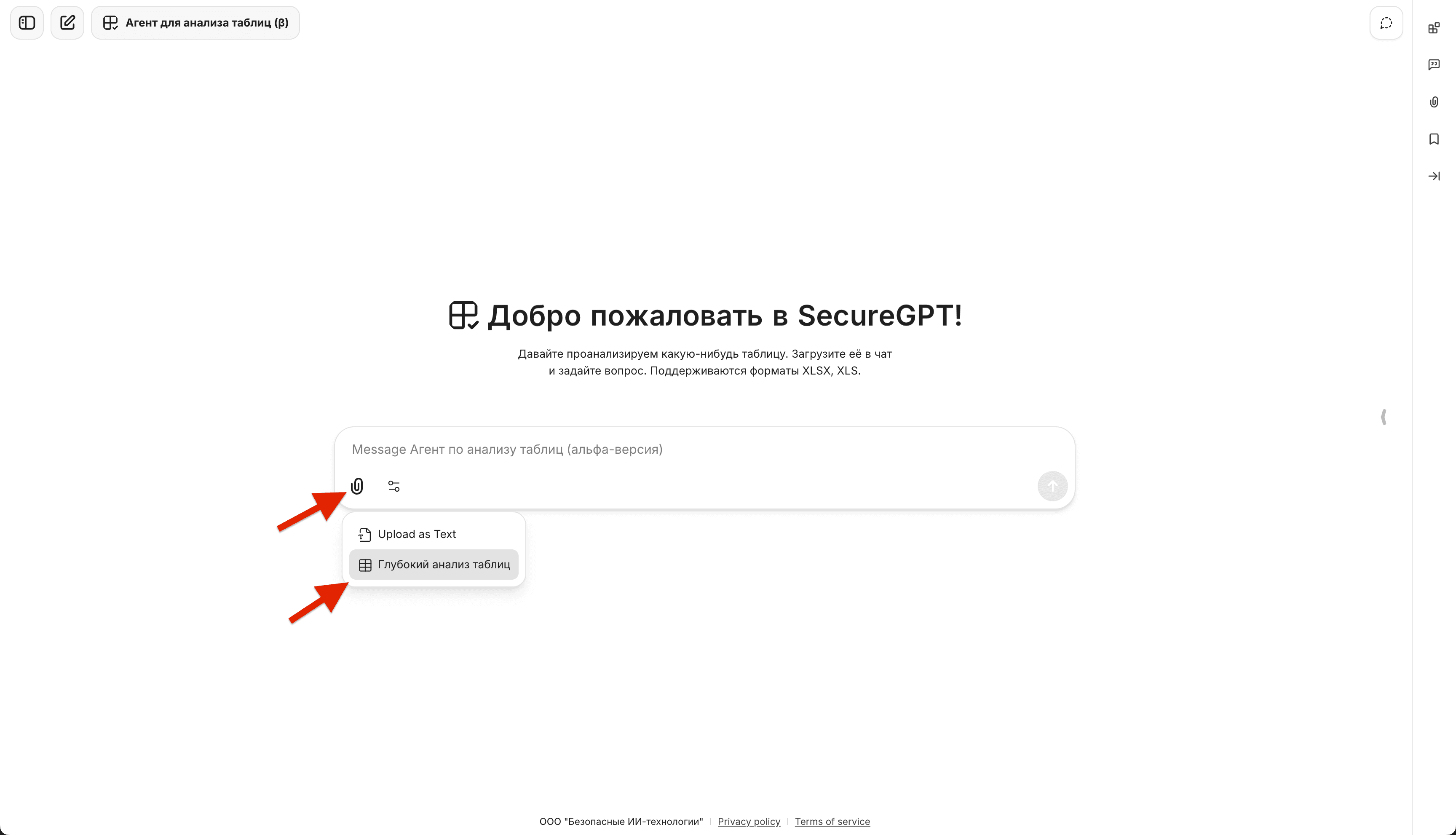

Шаг 3: Загрузите файл

- Нажмите на значок скрепки в поле ввода сообщения

- В появившемся меню выберите опцию загрузки «для глубокого анализа таблиц»

- Выберите нужный Excel-файл на вашем компьютере

Шаг 4: Начните анализ

После загрузки файл автоматически становится доступен агенту. Теперь можно задавать вопросы — например:

- "Какая общая выручка по регионам?"

- "В каком месяце был пик продаж?"

- "Сколько уникальных клиентов в базе?"

Агент проанализирует структуру таблицы и начнёт отвечать на основе реальных данных из вашего файла.

Лучшие практики: как добиться максимального результата

Эффективность табличного анализа зависит не только от возможностей инструмента, но и от того, как подготовлены данные и сформулированы вопросы.

Подготовка данных: профессиональный подход

Качество анализа напрямую зависит от структуры исходных данных. Загрузить таблицу «как есть» и ожидать точных результатов — распространённая ошибка. ИИ для анализа таблиц работает с тем, что получает — если данные хаотичны, результат будет ненадёжным.

Профессиональный подход требует 5-10 минут на предварительную подготовку файла. Это время окупается: вместо исправления ошибок в анализе вы сразу получаете точные результаты для принятия решений. Советуем обратить внимание на следующие моменты:

1. Чётко разделяйте логические области

Если в файле несколько таблиц — разместите их на отдельных листах. Если таблицы на одном листе — разделите пустыми строками. Это помогает системе корректно определить границы данных.

2. Понятные названия колонок и листов

Вместо "Кол-во" напишите "Количество_единиц". Вместо "Сумма1" — "Выручка_руб". Чем яснее названия, тем точнее анализ данных с помощью ИИ.

3. Говорящие названия листов

Вместо "Лист1", "Лист2" назовите листы по смыслу: "Продажи_Q1", "Расходы_2024". Это упростит навигацию и формулировку вопросов.

4. Строгая типизация данных

Каждая колонка должна содержать данные одного типа. Числа записывайте как числа — без пробелов, без приписок вроде "тыс. руб." или "шт.". Убедитесь, что в Excel ячейки отформатированы корректно: числовые колонки имеют числовой формат, даты — формат даты, текст — текстовый. Смешение типов в одной колонке (например, когда число записано как текст) приводит к ошибкам при вычислениях.

Как задавать вопросы, чтобы получать точные ответы

Избегайте общих, оценочных вопросов:

- "Как дела с продажами?"

- "Всё ли хорошо с клиентами?"

- "Проанализируй файл"

Такие запросы оставляют слишком много пространства для интерпретации. Система не знает, что именно вас интересует — динамика, структура, аномалии или что-то ещё.Формулируйте запросы как конкретные аналитические операции:

- "Какая общая выручка по каждому региону за 2024 год?"

- "В каком месяце был минимальный объём продаж?"

- "Сколько уникальных контрагентов в категории 'Поставщики'?"

- "Какой средний чек по клиентам из Москвы?"

Чем конкретнее вопрос — тем меньше пространства для импровизации. Система выполнит точный расчёт и вернёт результат, который можно сразу использовать в отчёте или презентации.

Попробуйте на своих данных

Теория работает, когда подкреплена практикой. Загрузите один файл — выгрузку из 1С, отчёт CRM или таблицу продаж. Задайте конкретный вопрос: "Какая выручка по регионам?" или "В каком месяце был пик расходов?". Проверьте результат.

Попробовать ИИ для анализа таблиц в SecureGPT →